Введение: зачем нужна техническая оптимизация в 2025 году

Вы собрали семантическое ядро сайта; понимаете, что на сайте должны быть поисковые запросы, по которым пользователи ищут ваши товары или услуги. Но, увы, кроме ключевых фраз продвижение сайта невозможно представить без технической оптимизации. Алгоритмы поисковых систем стали гораздо требовательнее: когда-то давно можно было обеспечить сайту позиции на первой странице только за счёт ссылок или наполнения ключевыми словами, но сегодня этого недостаточно. Google и Яндекс всё чаще ориентируются на пользовательский опыт (UX) и стабильность работы ресурса.

Техническая оптимизация — это процесс, который обеспечивает:

- корректную индексацию страниц;

- быстрое и стабильное открытие сайта на любых устройствах;

- соответствие современным стандартам безопасности;

- правильное взаимодействие с поисковыми роботами.

Даже если на сайте есть уникальный контент и мощная ссылочная поддержка, он не сможет занять высокие позиции в поисковой выдаче, если техническая часть работает со сбоями. Медленная загрузка, ошибки в коде, дублированные страницы или проблемы с адаптацией под мобильные устройства моментально снижают доверие поисковых алгоритмов.

Техническая оптимизация объединяет направления SEO, веб-разработки и цифровой безопасности. Она влияет не только на позиции в поиске, но и на бизнес-показатели: количество заявок, конверсию и лояльность клиентов.

Что такое техническая оптимизация сайта

Если просто: хорошая техническая оптимизация — это когда сайт не только удобен для пользователей, но и понятен для поисковых систем. Поисковикам нужен понятный сайт, людям — быстрый и удобный, бизнесу — безопасный и надёжный. Когда все три направления проработаны, сайт стабильно растет.

Вот короткий чек-лист, зачем вам обязательно нужна техническая оптимизация сайта:

- страницы открываются быстро и без ошибок;

- роботы легко сканируют сайт;

- пользователи получают комфортный опыт взаимодействия.

Результат — ваш сайт получает отличную репутацию от поисковых систем и чаще оказывается на первых позициях поисковой выдачи.

Как техническая оптимизация связана с SEO и бизнес-результатами

Техническая оптимизация — это основа поискового продвижения. Без неё любые усилия по работе с семантикой или ссылками могут оказаться напрасными.

Рассмотрим несколько факторов:

- если ваш сайт не адаптирован под смартфоны — он будет терять до 60% аудитории;

- если сайт долго загружается — роботы будут отслеживать этот показатель и это негативно повлияет на позиции;

- если SSL-сертификат не настроен, браузеры выводят предупреждения, и часть пользователей просто закрывает страницу.

Таким образом, техническая оптимизация напрямую связана с посещаемостью, конверсией и количеством заявок.

Почему без технической оптимизации контент и ссылки не работают

Поисковая система оценивает сайт комплексно. Даже лучший текст или сильный ссылочный профиль не принесут результата, если:

- роботы не могут проиндексировать страницу из-за ошибок в файле robots.txt;

- URL дублируются и распределяют ссылочный вес;

- сайт работает нестабильно и выдаёт коды ошибок: 500 или 404.

Именно поэтому техническая оптимизация — это не вспомогательный процесс, а равноправный элемент SEO-стратегии, который критически важен. Конкуренция за ТОП позиции в выдаче каждый год растёт, а значит, алгоритмы поисковых систем всё меньше прощают технические недочёты.

Основные задачи технической оптимизации

Корректная индексация

Главная цель технической оптимизации — сделать так, чтобы поисковые роботы могли быстро и без ошибок находить, сканировать и индексировать все важные страницы сайта. Если часть страниц недоступна или закрыта неправильно, поисковая система не сможет учитывать их в ранжировании. Особенно важно следить за тем, чтобы:

- не было дублей страниц;

- динамические фильтры и параметрические URL не засоряли индекс;

- sitemap.xml и robots.txt были настроены без конфликтов;

- структура сайта помогала роботам распознавать приоритетные страницы.

Ускорение загрузки страниц

Скорость загрузки сайта напрямую влияет на конверсию. Согласно исследованиям 2024 года, каждая дополнительная секунда задержки снижает количество заявок в среднем на 7–10 %. В 2025 году Google и Яндекс учитывают Core Web Vitals как один из ключевых факторов ранжирования.

Что включает в себя оптимизация скорости:

- работу с изображениями (WebP, AVIF, адаптивная загрузка);

- минимизацию CSS и JavaScript;

- внедрение кэширования и CDN;

- настройку серверного ответа.

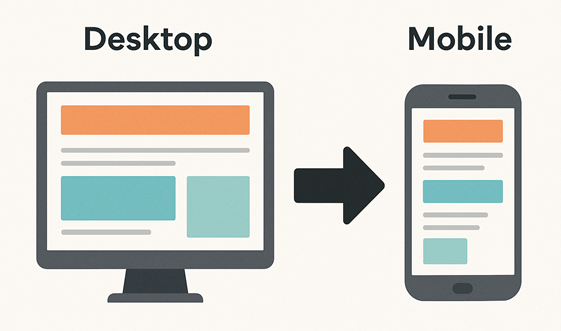

Удобство для мобильных пользователей

Mobile-First Index окончательно закрепился как стандарт, так как доля мобильного трафика растёт и уже составляет больше 60%. Это значит, что именно мобильная версия сайта теперь является приоритетной для поисковиков. Самое неожиданно для некоторых владельцев бизнеса: если сайт неудобен для смартфона, он теряет позиции даже в десктопной выдаче.

Поэтому важно использовать адаптивную верстку вместо отдельных мобильных версий, избегать горизонтальной прокрутки и мелкого текста и проверять удобство элементов управления: кнопки, формы, меню.

Самый надёжный способ проверить, всё ли хорошо — провести тестирование на реальных устройствах: смартфонах разных брендов и моделей. Подробнее о Mobile-First Index мы расскажем дальше в статье.

Безопасность и доверие

Безопасность сайта — это не только защита данных пользователей, но и фактор ранжирования. Современные браузеры и поисковики отмечают небезопасные сайты как потенциально опасные.

Что обязательно должно быть на вашем сайте:

- SSL-сертификат и работа только по HTTPS;

- регулярные обновления CMS и плагинов;

- защита от вредоносных скриптов и скрытых редиректов;

- резервное копирование данных.

Экономия краулингового бюджета

Каждый сайт имеет ограниченный краулинговый бюджет — количество страниц, которое робот готов просканировать за определённое время. Если робот тратит его на дубли, пустые страницы или технический мусор, то важные разделы могут остаться без индексации.

Задача технической оптимизации — сделать так, чтобы поисковики тратили ресурсы только на те страницы, которые должны участвовать в ранжировании. Для этого закрывают фильтры, настраивают канонические URL и оптимизируют структуру ссылок.

Скорость загрузки и Core Web Vitals

LCP, FID, CLS — что это за метрики и что важно знать о них

Core Web Vitals остаются базовыми метриками, которые учитывают как Google, так и Яндекс при ранжировании.

- LCP (Largest Contentful Paint) — время загрузки основного контента страницы. Норма — до 2,5 секунд.

- FID (First Input Delay) — время отклика страницы на первый пользовательский клик. В 2025 году Google продвигает новый показатель INP (Interaction to Next Paint), который учитывает стабильность отклика на протяжении всего взаимодействия.

- CLS (Cumulative Layout Shift) — визуальная стабильность интерфейса, то есть отсутствие сдвигов блоков при загрузке.

Для сайтов, где пользователь совершает быстрые действия (например, оформление заявки или покупка), FID/INP стали критически важными: даже задержка в доли секунды может привести к отказу.

Как оптимизировать изображения и видео

Причин медленной загрузки сайтов очень много, но главная по сей день — медиафайлы.

Что нужно знать и применять:

- использовать форматы WebP и AVIF — они в 2–3 раза легче JPEG при том же качестве;

- внедрять адаптивные изображения (srcset), чтобы мобильные устройства не загружали файлы, которые превышают достутимый установленный размер;

- применять Lazy Load для картинок и видео, чтобы они подгружались только при прокрутке страницы;

- хранить большие видео не на сервере, а на сторонних платформах (YouTube, Vimeo) или в CDN.

Нужна помощь с оптимизацией сайта?

Оставьте заявку – проведем детальный аудит, предложим решения и реализуем в кратчайшие сроки.

Минификация и работа со скриптами

Часть проблем со скоростью загрузки также может быть связана с JavaScript. Избыточные библиотеки, сторонние виджеты и неэффективный код перегружают сайт.

Какие решения использует команда Адекво:

- минимизируем CSS и JS, удаляем неиспользуемые стили;

- переносим скрипты, которые замедляют работу сайта, в конец документа или загружаем их асинхронно;

- используем современные фреймворки с упором на производительность (например, Next.js или Astro для фронтенда);

- отказываемся от лишних плагинов в CMS.

CDN и серверные решения

Даже оптимизированный сайт будет работать медленно, если сервер не справляется с нагрузкой. Поэтому техническая оптимизация включает работу с инфраструктурой:

- использование CDN (Content Delivery Network) для ускорения загрузки ресурсов в разных регионах;

- переход на HTTP/3 и протокол QUIC для ускорения передачи данных;

- внедрение кэширования на стороне сервера;

- выбор хостинга, который гарантирует высокое время безотказной работы (uptime не ниже 99,9 %).

Проверять скорость и Core Web Vitals можно через Google PageSpeed Insights, Lighthouse, WebPageTest, а также встроенные инструменты в Яндекс.Метрике.

Мобильная оптимизация и Mobile-First Index

Сегодня большинство пользователей ищут информацию не с компьютера, а со смартфона. Поэтому поисковики оценивают сайт прежде всего по тому, насколько удобно он работает на мобильных устройствах.

Подход Mobile-First Index означает, что именно мобильная версия сайта становится основной при ранжировании. Если контент, структура или функциональность на ней урезаны — страдает вся видимость ресурса, включая десктопную.

Современные требования Google и Яндекс

С 2021 года Google официально перешёл на Mobile-First Index, а к 2025 году это стало стандартом индустрии: оценка сайта идёт в первую очередь по мобильной версии. Яндекс также акцентирует внимание на юзабилити мобильных устройств.

Ключевые требования:

- контент на мобильной и десктопной версиях должен быть одинаковым;

- элементы интерфейса должны адаптироваться под размер экрана;

- никакого горизонтального скролла, некорректно отображающихся блоков и мелкого текста;

- страницы должны быстро открываться даже при слабом мобильном интернете.

Иными словами, если сайт удобен на смартфоне — он будет ранжироваться в поисковых системах выше.

UX-факторы для смартфонов

Пользовательский опыт на мобильных устройствах оценивается поисковиками не только технически, но и поведенчески. На что нужно обратить внимание:

- Размер кнопок и полей форм. Они должны быть удобны для нажатия пальцем, без необходимости масштабировать экран.

- Читаемость текста. Минимальный размер шрифта — 16px, адаптация межстрочных интервалов.

- Простая навигация. Меню должно быть интуитивным и не перегруженным.

- Стабильность верстки. Изображения и баннеры не должны смещать контент при загрузке (CLS).

- Отсутствие навязчивых элементов. Межстраничные поп-апы, перекрывающие экран, в 2025 году — один из факторов снижения позиций.

AMP, PWA и их влияние на SEO

Ранее Google активно продвигал AMP (Accelerated Mobile Pages), но к 2025 году их роль снизилась. Сегодня акцент сделан на PWA (Progressive Web Apps), которые превращают сайт в приложение:

- обеспечивают мгновенную загрузку за счёт кеширования;

- позволяют работать офлайн;

- увеличивают вовлечённость за счёт push-уведомлений.

PWA не является обязательным требованием, но даёт конкурентное преимущество: такой сайт быстрее, удобнее и ближе к пользовательскому формату мобильного приложения.

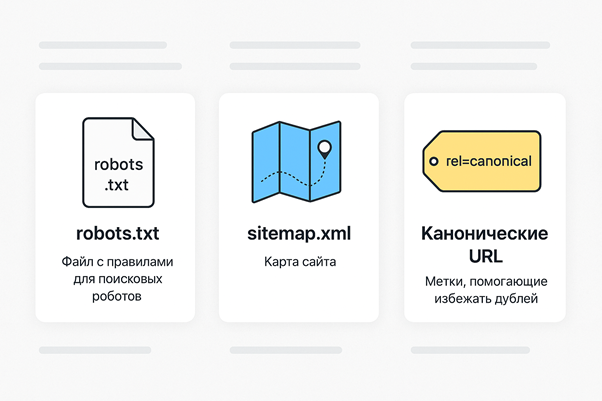

Индексация: robots.txt, sitemap.xml, канонические URL

На первый взгляд может показаться, что технические файлы сайта — это формальности: robots.txt разрешает или запрещает доступ к страницам, sitemap.xml помогает поисковику найти нужные разделы, а canonical указывает, какая страница основная.

Но для поискового робота это настоящая карта и правила движения по сайту. Именно от них зависит, какие страницы попадут в индекс, а какие останутся «за кадром».

Настройка robots.txt

Файл robots.txt остаётся основным инструментом для управления доступом поисковых роботов к страницам. Он размещается в корневой папке сайта и сообщает, какие разделы можно сканировать, а какие следует закрыть.

Что важно учитывать:

- закрывать от индексации технические страницы: корзина, личный кабинет клиента, формы заявки;

- не допускать противоречий с мета-тегами: например, Disallow в robots.txt и одновременно Index в meta;

- проверять корректность файла через Google Search Console и Яндекс.Вебмастер;

- использовать директиву Host для Яндекса и учитывать Crawl-delay только при необходимости.

Ошибки в robots.txt могут привести к тому, что в индекс попадут лишние страницы или, наоборот, важные разделы будут скрыты.

Динамические и статические карты сайта

Sitemap.xml помогает поисковым системам быстрее находить страницы. Современные CMS умеют автоматически обновлять карту, но это не отменяет ручной проверки.

На что нужно обращать внимание:

- включать только рабочие URL с кодом ответа 200;

- исключать страницы, закрытые от индексации;

- указывать приоритет страниц и дату последнего обновления;

- использовать отдельные sitemaps для изображений и видео, если их много на сайте.

Для крупных сайтов актуален формат динамических карт сайта — они обновляются автоматически при добавлении новых страниц.

Борьба с дублями и параметрическими URL

Дубли страниц снижают эффективность индексации и размывают ссылочный вес. В 2025 году особое внимание уделяется:

- версиям страниц со слешем и без (/catalog и /catalog/);

- параметрическим URL (?sort=price, ?page=2);

- дублям из-за фильтров и пагинации;

- дублированию между поддоменами и зеркалами.

Чтобы устранить проблему, используют:

- тег rel="canonical";

- запрет индексации фильтров и сортировок;

- редиректы 301 на основную версию страницы.

Карта релевантности и внутренняя структура

Чтобы поисковики правильно определяли значимость страниц, важно распределить запросы и ключи в карте релевантности. Это помогает избежать конкуренции собственных страниц — каннибализации.

Кроме того:

- структура должна быть логичной и не глубже 3–4 уровней;

- каждая страница должна иметь внутренние ссылки;

- путь навигации на странице (строку, которую называют ещё как «хлебные крошки») — помогают как пользователям, так и роботам лучше ориентироваться в иерархии сайта.

Именно настройка индексации определяет, какие страницы сайт откроет поисковым системам. От этого зависит, увидят ли пользователи ваш ресурс в выдаче по целевым запросам.

Редиректы, ошибки 404 и работа с серверными кодами

Когда использовать 301 и 302

Редиректы нужны для корректного перенаправления пользователей и поисковых роботов с одного URL на другой.

- 301 (Moved Permanently) — постоянный редирект. Используется, когда страница окончательно перенесена: смена структуры сайта, объединение зеркал, переход на HTTPS. Передаёт до 100 % ссылочного веса.

- 302 (Found / Temporary Redirect) — временный редирект. Применяется, если страница недоступна на время или проводится тестирование. Но для SEO по-прежнему предпочтителен 301.

Ошибки при работе с редиректами:

- цепочки редиректов — замедляют загрузку и расходуют краулинговый бюджет;

- циклические редиректы — блокируют доступ к странице;

- использование 302 вместо 301 при постоянных изменениях.

Избегаем цепочек редиректов

Цепочка из нескольких редиректов увеличивает время отклика и снижает скорость загрузки. Поисковые роботы могут просто не пройти до конечного URL, особенно если в цепочке более трёх звеньев.

Рекомендации:

- при переносе страниц делать редирект сразу на конечный адрес;

- регулярно проверять сайт с помощью Screaming Frog, Netpeak Spider или аналогов;

- минимизировать количество редиректов при миграции сайтов.

Польза кастомных 404-страниц

Ошибка 404 (Not Found) возникает, если страница недоступна. Для SEO это риск:

- пользователи уходят с сайта, что повышает показатель отказов;

- поисковики расходуют краулинговый бюджет на пустые URL.

Но правильно оформленная 404-страница снижает негатив:

- помогает пользователю вернуться на главную или в нужный раздел;

- содержит поиск по сайту или ссылки на популярные страницы;

- визуально соответствует дизайну сайта, не создавая ощущения неисправности.

Важно: не путать 404 и 410 (Gone). Код 410 сообщает поисковикам, что страница удалена навсегда, и её можно быстрее убрать из индекса.

Также нужно следить, чтобы ошибки 404 не подменялись кодом 200 (soft 404). Такие страницы вводят поисковики в заблуждение и могут привести к пессимизации сайта в поисковой выдаче.

Архитектура сайта и внутренняя перелинковка

Принципы плоской структуры

Структура сайта должна быть логичной: тогда поисковым роботам и пользователям проще находить нужную информацию.

Один из принципов, который применяют специаслисты Адево — плоская структура:

- глубина вложенности страниц не более трёх кликов от главной;

- категории и подкатегории должны быть логично связаны;

- каждая страница должна иметь понятный URL (читаемый, без лишних параметров).

Чем меньше уровней вложенности, тем быстрее новые страницы попадают в индекс и тем выше шанс, что они получат органический трафик.

Хлебные крошки и юзабилити

Навигационные цепочки («хлебные крошки») помогают пользователю понимать, где он находится, и быстро вернуться на предыдущую страницу или раздел сайта.

Для SEO они также важны, так как отражают иерархию сайта, формируют дополнительные внутренние ссылки, могут отображаться в сниппетах в поисковой выдаче.

В 2025 году поисковики рекомендуют использовать микроразметку для хлебных крошек по стандарту Schema.org. Это делает сниппеты более заметными и улучшает CTR.

Перелинковка для SEO и поведенческих факторов

Внутренняя перелинковка решает сразу несколько задач:

- распределяет ссылочный вес между страницами;

- ускоряет индексацию новых материалов;

- повышает глубину просмотра и снижает показатель отказов;

- помогает пользователю находить дополнительную информацию.

Принципы качественной перелинковки:

- ссылки должны быть тематическими и логичными;

- важно использовать анкорные тексты с ключевыми словами, но без переспама;

- нужно избегать «свалки ссылок» в одном блоке — 5–7 релевантных ссылок достаточно.

Для крупных сайтов всё чаще применяют динамическую перелинковку: алгоритмы автоматически подбирают ссылки на основе поведенческих данных и интереса аудитории.

SSL, безопасность и защита данных

HTTPS как стандарт

Если сайт работает по протоколу http://, браузеры автоматически выводят предупреждения о небезопасном соединении. Это снижает доверие пользователей и приводит к падению конверсии.

«Наличие SSL-сертификата — обязательное условие».

Преимущества HTTPS:

- защищённая передача данных (особенно важна для форм заявок и онлайн-оплат);

- повышение доверия поисковых систем;

- отсутствие предупреждений о небезопасном сайте;

- репутация со стороны поисковых роботов при ранжировании сайта.

На практике достаточно бесплатного сертификата, но для интернет-магазинов и сервисов с персональными данными предпочтительнее такие решегния, как Wildcard SSL, который действует сразу на все поддомены определённого домена.

Борьба с вредоносным кодом

Поисковые системы регулярно проверяют сайты на наличие вредоносных скриптов. В случае заражения сайт может:

- перестать индексироваться в поисковых системах;

- показывать пользователям предупреждения об опасности;

- подвергнуться утечке данных клиентов.

Чтобы избежать этого, регулярно проверяйте ограничения прав доступа к серверу, подключите двухфакторную авторизацию для администраторов, защиту от SQL-инъекций и XSS-атак и проводите аудит кода — сканирование антивирусами и специализированными сервисами.

Резервное копирование и обновления

Даже идеально защищённый сайт не застрахован от сбоев. Поэтому обязательным элементом технической оптимизации остаётся резервное копирование.

Рекомендации Адекво:

- делать ежедневные автоматические бэкапы на внешний сервер или облако;

- хранить несколько последних копий (как минимум за неделю и месяц);

- проверять восстановление данных, а не только сам факт создания копии.

Не менее важно — регулярно обновлять CMS, плагины и модули. Устаревшие версии становятся уязвимыми, и именно они чаще всего используются злоумышленниками для атак.

Безопасность сайта — обязательное условие для SEO и бизнеса.

Качество кода и микроразметка

Валидация HTML/CSS

Поисковые роботы научились корректно обрабатывать даже проблемный код, но тренд очевиден: сайты с чистой, валидной разметкой индексируются быстрее и реже сталкиваются с ошибками отображения.

Основные требования:

- отсутствие устаревших тегов и атрибутов;

- корректная вложенность элементов;

- уникальные ID и отсутствие дублирования;

- минимизация инлайновых стилей.

Для проверки используют валидаторы, которые проверяют соответствие веб-страниц стандартам W3C, а также встроенные инструменты в системах CI/CD — это позволяет находить ошибки ещё на этапе разработки и релизов.

JSON-LD и Schema.org

Микроразметка по стандарту Schema.org стала обязательным элементом оптимизации. Последнее время рекомендуется использовать именно формат JSON-LD, так как он наиболее удобен для поисковых систем и легко внедряется без изменения верстки.

С помощью разметки можно описывать:

- товары (название, цена, наличие, рейтинг);

- статьи и публикации (автор, дата, категория);

- организации и локальные компании (адрес, телефон, часы работы);

- отзывы и раздел с вопросами и ответами;

- хлебные крошки.

Правильно внедрённая микроразметка помогает формировать расширенные сниппеты, которые привлекают внимание и увеличивают CTR в выдаче.

Расширенные сниппеты и CTR

Современные сниппеты в поисковых системах выходят за рамки простого заголовка и описания. В 2025 году они могут содержать:

- изображения и иконки;

- блоки «Вопрос-ответ»;

- рейтинг и количество отзывов;

- цену и наличие товара;

- быстрые ссылки на разделы сайта.

Всё это повышает кликабельность ссылки и помогает обойти конкурентов даже при одинаковых позициях.

Таким образом, чистый код и правильно внедрённая микроразметка — это инструмент прямого влияния на поведенческие метрики, который одновременно улучшает восприятие сайта пользователями и упрощает его интерпретацию поисковыми системами.

Оптимизация изображений и мультимедиа

WebP, AVIF и современные форматы

Вместо JPEG используйте форматы WebP и AVIF. Они обеспечивают высокое качество при минимальном размере файла и поддерживаются всеми современными браузерами.

Рекомендации:

- использовать WebP как базовый формат;

- для сложной графики с высоким уровнем детализации — AVIF;

- избегать загрузки изображений без предварительной конвертации: например в форматах TIFF или BMP.

Такой подход позволит сократить вес страниц на 30–70 % без потери качества.

Lazy Load и адаптивные изображения

Для ускорения загрузки применяется отложенная загрузка, она же Lazy Load. Работает это так: изображения загружаются только тогда, когда пользователь доходит до них при прокрутке страницы. Это значительно снижает время первичной загрузки.

В свою очередь, адаптивные изображения (srcset) позволяют браузеру подбирать файл нужного размера в зависимости от устройства. Таким образом, смартфон получает картинку 800px вместо 2000px, что экономит трафик и ускоряет работу сайта.

Работа с видео и подкастами

Медиафайлы становятся важной частью сайтов, но они могут перегружать сайт и влиять на производительность. Чтобы решить эту проблему, можно внедрить одну из следующих стратегий:

- хранение тяжёлых файлов на сторонних платформах или CDN;

- использование форматов WebM и MP4 с адаптивным битрейтом;

- отложенная загрузка видеоплееров;

- отключение автозапуска видео и аудио, чтобы не мешать пользователю и не перегружать устройство.

Для подкастов и обучающих материалов внедряют микроразметку Podcast и VideoObject, чтобы контент отображался в расширенных сниппетах поисковых систем.

Оптимизация изображений и мультимедиа напрямую влияет на скорость загрузки, Core Web Vitals и поведенческие факторы. Сайт, который работает легко и быстро даже с большим количеством графики, получает преимущество в поисковой выдаче.

Краулинговый бюджет и контроль индексации

Как поисковики расходуют crawl budget

Как уже было написано, краулинговый бюджет — это количество страниц, которое поисковый робот готов просканировать за определённый период. И его экономия становится важнее с каждым годом, так как объём сайтов растёт, а алгоритмы Google и Яндекс усилиливают фильтрацию страниц.

Что влияет на расход краулингового бюджета:

- скорость отклика сервера;

- количество ошибок (404, 500, редиректов);

- дублированный контент;

- внутренние ссылки.

Если робот тратит бюджет на второстепенные страницы, например, фильтры, пустые разделы, технические URL, то ключевые разделы могут остаться неиндексированными.

Инструменты контроля индексации

Google Search Console — разделы «Страницы» и «Покрытие» показывают, какие URL проиндексированы, а какие исключены;

Яндекс.Вебмастер — вкладка «Индексирование сайта»;

Screaming Frog, Netpeak Spider — помогают сравнить общее количество страниц с теми, что реально попали в индекс;

log-файлы сервера — позволяют отследить поведение поисковых роботов и понять, какие страницы они сканируют чаще всего.

Удаление мусорных страниц

Чтобы экономить краулинговый бюджет, важно закрывать от индексации страницы, которые не должны принимать внешний трафик из поисковых систем:

- страницы поиска по сайту;

- фильтры и сортировки;

- технические разделы (корзина, личный кабинет пользователя, страница оформления заказа);

- дублированные страницы с параметрами.

Регулярный контроль индексации и грамотное распределение бюджета позволяют добиться того, чтобы поисковики индексировали только те страницы, которые реально важны для бизнеса.

Технические аспекты контента

Уникальность и дубликаты

Даже качественный текст теряет ценность, если он повторяется на разных страницах. Современные алгоритмы поисковых систем стали ещё строже к дублированному контенту:

- одинаковые описания товаров на сайте и в каталоге производителя приводят к наложению фильтров;

- копии страниц, доступные по разным URL, делят ссылочный вес;

- тексты с минимальным изменением, если это, например, рерайт и уникальность текста слишком низкая.

Тщательно проверяйте контент, который публикуете, на уникальность. Это касается не только текстов, но и изображений. Для этого можно использовать как онлайн-сервисы, так и программное обеспечение с установкой на ваше устройство.

Мета-теги Title и Description

Каждая страница сайта должна иметь уникальные мета-теги.

- Title: до 60 символов, ключевые слова ближе к началу, уникальность обязательна.

- Description: до 160 символов, краткое описание содержания страницы, включающее призыв к действию.

Самые распространённые ошибки:

- одинаковые теги для разных страниц;

- автоматическая генерация без проверки;

- переспам ключами.

Обратите внимание, что поисковики могут подставлять собственные сниппеты, если Description нерелевантен или отсутствует.

Структура текста для SEO и UX

Технически грамотный текст должен быть удобен не только для пользователей, но и для алгоритмов.

Вот как выглядит структура текста для поискового робота:

- заголовок H1 — один на страницу, отражает главный запрос;

- подзаголовки H2–H3 разбивают текст на логические блоки;

- списки и таблицы делают информацию компактной;

- изображения имеют атрибуты alt и title;

- объём текста соответствует тематике (слишком короткий текст хуже ранжируется).

Кроме того, важно следить за читабельностью: длинные абзацы разбиваются на 3–4 строки, язык должен быть простым и без перегруженности терминами. Это снижает показатель отказов и увеличивает глубину просмотра.

В итоге технические аспекты контента помогают соединить SEO-задачи (ключевые запросы и релевантность) и UX-задачи (удобство и удержание пользователя).

Мониторинг и регулярный аудит

Инструменты для проверки сайта

Даже идеально настроенный сайт со временем накапливает ошибки: устаревшие плагины, битые ссылки, дубли страниц, конфликты скриптов. Поэтому регулярный аудит обязателен.

- Google Search Console и Яндекс.Вебмастер — базовый контроль индексации, ошибок сканирования и мобильной адаптации.

- Screaming Frog SEO Spider — глубокий технический анализ структуры, редиректов, дублей.

- Ahrefs, Semrush — мониторинг видимости, внешних ссылок и ошибок на уровне всего сайта.

- PageSpeed Insights — диагностика скорости и Core Web Vitals.

- лог-анализаторы (например, JetOctopus) — показывают, как именно роботы сканируют сайт, где теряется краулинговый бюджет.

Автоматизация аудита

Современные проекты используют DevOps-подход: ошибки контролируются не только после релиза, но и на этапе разработки. В 2025 году популярна интеграция SEO-проверок в CI/CD:

- автоматическая проверка валидности кода;

- анализ скорости при каждом обновлении;

- тестирование микроразметки;

- мониторинг доступности сервера и SSL-сертификата.

Это позволяет не допускать массовых ошибок, которые могут пессимизировать позиции сайта в поисковой выдаче.

Когда нужен экспертный аудит

Самостоятельные проверки полезны, но не всегда достаточны. Экспертный аудит нужен, если:

- сайт готовится к миграции на новую CMS или домен;

- планируется масштабирование (новые языковые версии, поддомены);

- произошёл резкий спад трафика без очевидных причин;

- проект работает в высококонкурентной сфере, где важна каждая деталь.

Экспертный аудит включает не только выявление проблем, но и составление плана приоритетных работ: что нужно исправить в первую очередь, а что можно отложить. Это позволяет экономить ресурсы и получать быстрый эффект.

Заключение: техническая оптимизация как непрерывный процесс

Техническая оптимизация — это постоянная работа, которая требует регулярного внимания. Поисковые системы учитывают сотни факторов, и большая их часть связана именно с технической составляющей.

Основные выводы:

- Без технической базы невозможно эффективно развивать контент и ссылочную стратегию.

- Скорость загрузки, безопасность и удобство для мобильных устройств стали обязательными условиями для попадания в топ.

- Правильная настройка индексации, работа с редиректами и устранение дублей напрямую влияют на видимость сайта.

- Чистый код, микроразметка и современная работа с мультимедиа повышают CTR и улучшают восприятие ресурса.

- Краулинговый бюджет нужно экономить: чем эффективнее он распределён, тем быстрее индексируются ключевые страницы.

- Регулярный аудит помогает предотвращать ошибки и поддерживать стабильный рост.

Для бизнеса техническая оптимизация — это основа, от которой зависят конверсии, доверие пользователей и долгосрочная конкурентоспособность.

Правильно настроенный сайт:

- быстрее начинает индексироваться;

- удерживает посетителей;

- безопасно работает с данными клиентов;

- гибко адаптируется к изменениям алгоритмов Google и Яндекс.

Как показывает практический опыт Адекво, выигрывают не те компании, которые сделали хороший сайт при запуске, а те, кто воспринимает техническую оптимизацию как часть бизнес-процессов — постоянно контролирует параметры, обновляет техническую часть и развивает сайт комплексно.

Понравилась статья?

Поделиться