Пора признать: большинство A/B-тестов в рекламе – это иллюзия контроля. Различия вроде CTR 1,2% vs 1,4% в 80% случаев оказываются статистическим шумом, а не прорывом. Причина? Синдром «быстрого результата»: маркетологи меняют по 5 переменных, смотрят на данные за 3 дня и принимают решение, основанное на случайной флуктуации. Погоня за призрачными улучшениями съедает львиную долю тестового бюджета без какой-либо окупаемости.

Ошибка не в инструментах тестирования, которые стали очень продвинутыми. Ошибка – в методологической неграмотности. Мы разберем, как строить эксперименты по стандартам data-науки, чтобы каждое ваше решение было подкреплено железобетонными доказательствами, а не догадками.

Главный вопрос перед запуском: хватит ли данных

Прежде чем создавать эксперимент, стоит открыть калькулятор выборки. Не после теста, чтобы понять, можно ли доверять результатам, а до – чтобы понять, есть ли смысл начинать.

Математика простая. При текущей конверсии 2% и ожидании улучшения на 20% (то есть до 2,4%) для статистической значимости 95% нужно около 4 000 посетителей на каждый вариант. Если на сайт приходит 100 человек в неделю – тест займет почти год. Результат, полученный раньше, будет не более чем случайным колебанием.

| Текущая конверсия | Ожидаемое улучшение | Нужно посетителей на вариант | При 500 визитах/нед. — срок теста |

|---|---|---|---|

| 1% | +30% (до 1,3%) | ~14 000 | 28 недель |

| 2% | +20% (до 2,4%) | ~4 000 | 8 недель |

| 5% | +15% (до 5,75%) | ~2 800 | 6 недель |

| 10% | +10% (до 11%) | ~3 200 | 6,5 недель |

Вывод, который меняет всё: если ваш трафик мал, A/B-тестирование классических объявлений бессмысленно.

Вы просто документально оформите случайные колебания. Официальная рекомендация Яндекс.Директа – не менее 200 конверсий в месяц на тестируемую кампанию для каких-либо надежных выводов.

Случаи, когда тест не просто бесполезен, но и вреден

Не каждое решение требует эксперимента. Ниже – 3 основных ситуации, когда A/B-тест не принесет пользы.

Проверка очевидного

Сравнивать кричащий баннер с пастельным – это не тест, это растрата ресурсов. Здравый смысл и юзабилити-тесты должны идти впереди статистики.

Мультивариантное тестирование без контроля

Изменили заголовок, картинку и CTA одновременно? Поздравляем, вы провели не A/B-тест, а «черный ящик». Если вариант победил, вы никогда не поймете, какой элемент был решающим. Последующее применение «победившего» элемента по отдельности даст непредсказуемый результат, что подрывает саму идею накопления экспертизы.

Тест без сформулированной гипотезы

Гипотеза – это стержень эксперимента.

Пример сильной гипотезы: «Замена студийного фото автомобиля на изображение с семьей в парке повысит конверсию в заявку на 15% среди аудитории 30-45 лет, так как сильнее вовлекает через эмоцию "заботы о близких"».

Слабая гипотеза: «Давайте попробуем другую картинку».

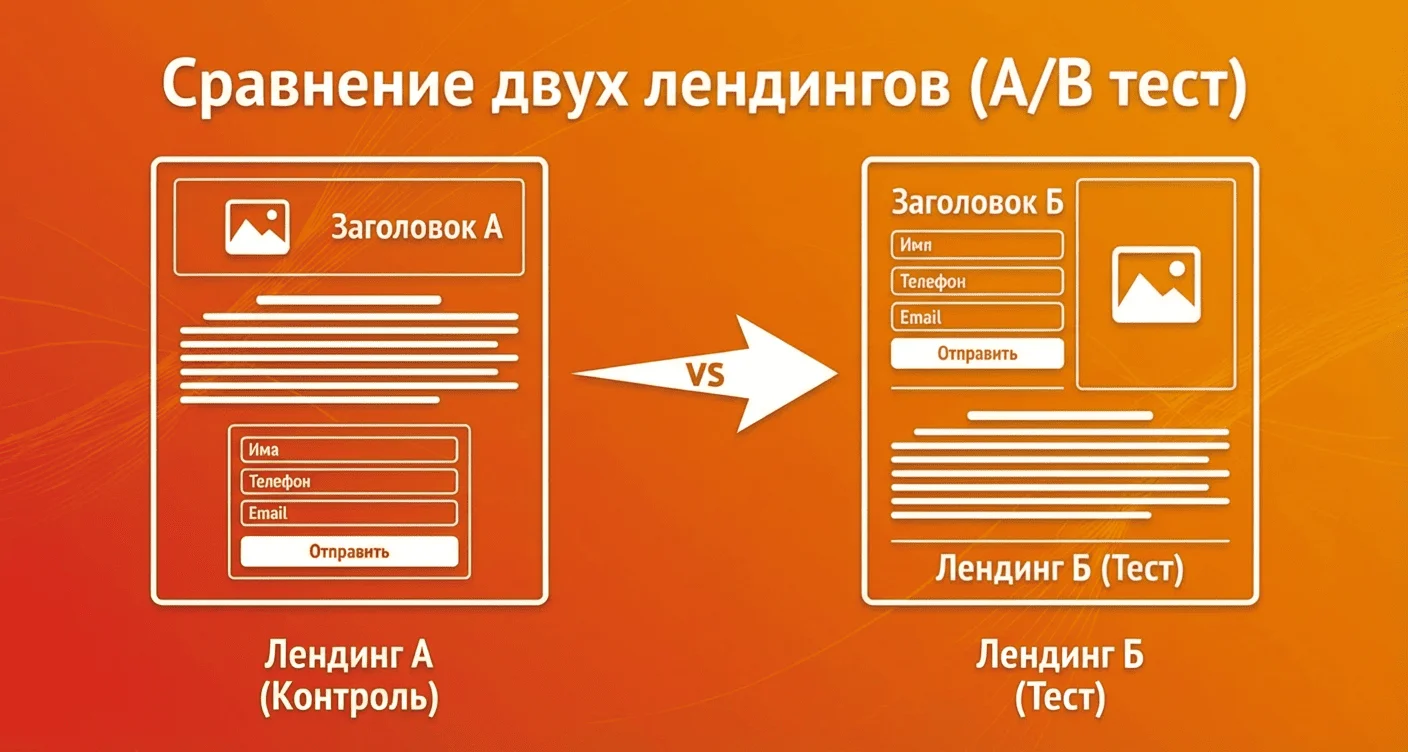

Как работают эксперименты в Яндекс Директе

В июне 2025 года A/B-эксперименты в Директ Про вышли из бета-тестирования. Раздел доступен в меню «Библиотека» → «A/B-эксперименты» и напрямую из настроек кампаний.

Директ делит аудиторию на случайные непересекающиеся сегменты. Каждый пользователь попадает только в одну группу на протяжении всего эксперимента – это исключает ситуацию, когда один человек взаимодействует с обоими вариантами.

Размер сегментов задается вручную: от 1 до 99%, необязательно 50/50.

Для запуска создаются две кампании (система поддерживает от 2 до 20 вариантов), идентичные во всём, кроме тестируемого параметра. После запуска результаты отображаются с цветовой индикацией значимости.

Ограничения инструмента: не более 50 активных экспериментов одновременно, не более 50 уникальных кампаний в одном эксперименте, от 2 до 20 вариантов.

При использовании автоматических стратегий есть дополнительное условие: для корректной работы алгоритма нужно минимум 10 конверсий в неделю на кампанию. Также учтите, что при разделении аудитории пополам каждый вариант получит примерно по 5 – этого недостаточно для обучения. Эксперименты со стратегиями имеет смысл проводить только на кампаниях с высоким объемом.

Почему две недели – минимум

Частая ошибка – останавливать эксперимент, когда один вариант «вырывается вперед». На третий день CTR варианта Б выше на 30% – кажется, ответ очевиден. Но ранние результаты ненадежны: статистика может выровняться или перевернуться.

Дело не только в объеме данных. Поведение аудитории циклично: будни отличаются от выходных, начало месяца – от конца. Тест, проведенный только в рабочие дни, даст искаженную картину для кампании, которая работает круглосуточно. Для продуктов с длинным циклом решения (автомобили, недвижимость, B2B) рекомендуемая продолжительность 3-4 недели. За это время часть аудитории успевает пройти путь от первого контакта до целевого действия.

Нужно дождаться полного цикла:

- Недельные циклы. Поведение в понедельник и субботу радикально отличается.

- Бизнес-циклы. Для автодилеров активность выше в конце месяца; для B2B — в середине недели.

- Цикл принятия решения. Для сложных товаров (недвижимость, оборудование) между первым кликом и заявкой может пройти 14-21 день. Короткий тест просто не захватит этот лаг.

Рекомендация: 14 дней – абсолютный минимум. Для среднего и высокого ценового сегмента реалистичный срок – 3-4 полные недели.

Давайте делать

крутые проекты вместе

Укажите в заявке ваше имя и номер телефона.

Наши менеджеры свяжутся с вами, ответят на все вопросы и подготовят коммерческое

предложение!

Три ошибки при интерпретации

1. Спутать статистическую значимость с практической ценностью. Калькулятор показывает: разница между вариантами значима с вероятностью 95%. Но разница – 0,2 процентных пункта конверсии. При стоимости заявки 3 000 рублей и 100 заявках в месяц экономия составит несколько тысяч рублей. Стоило ли это двух недель разделенного бюджета – вопрос.

2. Проигнорировать контекст. Тест в январе (низкий сезон для многих ниш) даст результаты, нерелевантные для марта. Эксперимент во время акции производителя – данные, неприменимые к обычному периоду. Результаты портативны только в похожих условиях.

3. Оптимизировать промежуточную, а не бизнес-метрику.

Вариант А: CTR 1.5%, Конверсия в заявку 1%, Стоимость заявки = 3 000 ₽

Вариант Б: CTR 0.9%, Конверсия в заявку 2.5%, Стоимость заявки = 1 200 ₽

По CTR лидирует А. По деньгам победитель – Б, с преимуществом в 150%.

Что тестировать: дорожная карта от простого к сложному

Элементы объявлений, такие как заголовки, тексты и изображения, – базовый уровень.

Яндекс частично автоматизирует процесс: при загрузке нескольких вариантов в группу система сама распределяет показы. Но есть минус – отсутствие контроля и понимания, почему один вариант победил.

Креативы (баннеры, заголовки): быстро, однако часто дает микро-оптимизации. Автоматизация в Директе упрощает процесс, но лишает глубины анализа

Настройки кампаний (стратегии, структура ключей, корректировки) требуют полноценного эксперимента с разделением аудитории. Здесь важно помнить об ограничении по конверсиям для автостратегий.

Стратегии и ставки: требует огромного трафика из-за условий обучения алгоритмов. Самый рискованный и долгий тип тестов.

Посадочные страницы влияют на результат не меньше объявлений, но тестируют их реже.

Посадочные страницы (самая большая возможность): по данным ConversionXL, оптимизация посадочной страницы дает в среднем на 30-50% больший прирост конверсии, чем игра с объявлениями. Но тестируется реже всего.

Итог: что делает A/B-тестирование по-настоящему эффективным

A/B-тесты в контекстной рекламе дают конкурентное преимущество только тогда, когда выстроены как полноценный исследовательский процесс. Все остальное – шум.

Но удерживать в голове все требования (от формулировки гипотезы до расчета выборки и выбора бизнес-метрики) сложно даже опытному специалисту. Поэтому мы подготовили удобный чек-лист для запуска эксперимента.

Получить чек-листЭтот документ – не просто список действий. Это методология, которую используют data-отделы сильнейших performance-агентств. Заполните его перед каждым тестом, чтобы исключить случайность, статистический шум и принятие решений «на глаз». Превратите ваши эксперименты из лотереи в источник гарантированного роста ключевых метрик.

Как использовать шаблон:

- Создайте копию этого документа для каждого нового A/B-теста;

- Строго следуйте заполнению ДО нажатия кнопки «Запустить кампанию»;

- Обсуждайте гипотезу и критерии с командой на основе этого документа, а не «ощущений»;

- Храните архив завершенных шаблонов – это ваша база знаний о том, что реально работает для вашего бизнеса.

Такой подход – ваша страховка от ложных открытий и гарантия, что каждый потраченный на тесты рубль приносит действительно полезные данные.

Понравилась статья?

Поделиться